Apple ha creado una red neuronal que puede “photoshopear” imágenes basándose en descripciones de texto

Los investigadores de Apple han desarrollado un nuevo modelo de inteligencia artificial que permite a los usuarios describir en un lenguaje sencillo lo que quieren cambiar en una foto. Al mismo tiempo, puedes editar imágenes sin siquiera tocar un software de edición de fotos.

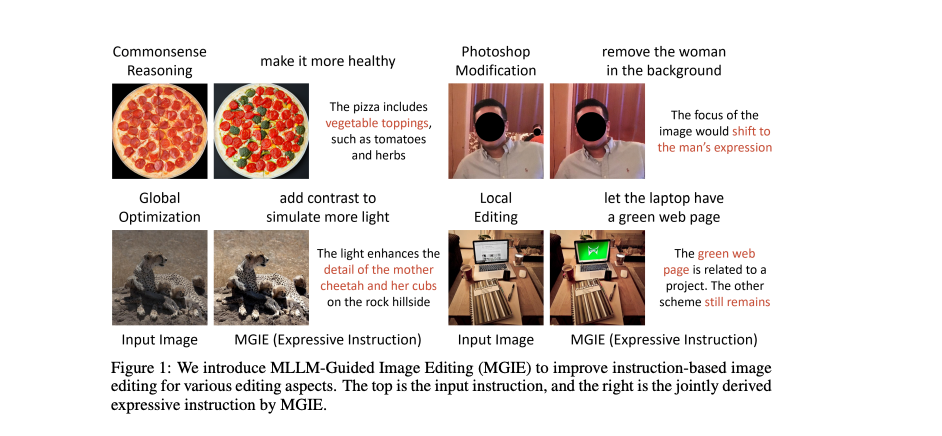

El modelo MGIE (edición de imágenes guiada por MLLM), en el que Apple ha trabajado en colaboración con la Universidad de California en Santa Bárbara, permite recortar, redimensionar, voltear y añadir filtros a las imágenes mediante indicaciones de texto. Este modelo también puede utilizarse para tareas de edición de imágenes más complejas, como dar nueva forma a determinados objetos de una foto para darles otra forma o hacerlos más brillantes.

MGIE combina dos tipos diferentes de uso de modelos lingüísticos multimodales. En primer lugar, aprende a interpretar las indicaciones del usuario. A continuación, “imagina” qué aspecto tendrá la edición (por ejemplo, una petición de un cielo más azul en una foto da como resultado un aumento del brillo de la parte de la imagen con el cielo).

Al editar una foto con MGIE, los usuarios sólo tienen que imprimir lo que quieren cambiar en la imagen. Por ejemplo, al editar una imagen de una pizza de pepperoni, puedes escribir “hazla más sana” y el modelo añadirá ingredientes vegetales. La foto de los tigres en el Sáhara parece oscura, pero después de decir a los modelos que “añadieran más contraste para simular más luz”, la imagen se volvió más brillante.

“En lugar de instrucciones breves pero ambiguas, MGIE detecta la intención visual explícita y conduce a la edición inteligente de imágenes”, afirman los investigadores en el artículo.

Apple ha puesto MGIE a disposición para su descarga a través de GitHub y también ha publicado una demostración web de Hugging Face Spaces. La empresa no especificó sus planes futuros para este modelo.